「ChatGPT」など大規模言語モデルの仕組みと土木領域での可能性【土木×AI第19回】:“土木×AI”で起きる建設現場のパラダイムシフト(19)(2/2 ページ)

ChatGPTで、スマートシティーとスマートモビリティの論文発表を分類

大規模言語モデルは、膨大な文章のパターンを学習していると考えられますから、人間に近い受け答えが実現されることは自然に想像できます。しかし、それだけにとどまらず、論理的な推論や分類などでも、適切な結果を導き出すことが知られています。

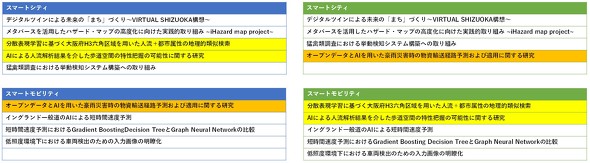

下図は、AIデータサイエンスシンポジウム※5での「スマートシティー」と「スマートモビリティ」のプログラムを対象に、ChatGPTに論文タイトルのみをそのまま投げて、それぞれのカテゴリーで分類してみた結果が右表です。ここでは、左表の実際に開催したときの人の手によるプログラム分けと、よく似た結果が得られています。

黄色でハイライトした人流関係の論文をスマートモビリティに、オレンジの災害時の交通の論文をスマートシティーに分類しているところが違いますが、それでもプログラムとして成立しますので、適切に分類できていると言えましょう。このように、データの整理や分類などの作業の効率化にも役立ちます。

※5 AI・データサイエンス特別シンポジウム「デジタルツイン」 プログラム/土木学会 構造工学委員会 AI・データサイエンス論文集編集小委員会/2023年3月23日

ちなみに、スマートシティーとスマートモビリティの違いを100文字程度にまとめるように、ChatGPTに問いかけたところ、「スマートシティーは都市全体の持続可能性を向上させるための総合的なアプローチであり、サービスやインフラの統合的な管理を目指す。スマートモビリティは交通システムと移動手段に焦点を当て、効率性や持続可能性を向上させる。」との回答でした。

Transformerをインフラ画像点検などにも適用できる「Vision Transformer」

Transformerは、言語のみならず画像にも適用可能です。その手法である「Vision Transformer」は、下図のように画像をパッチに分け、そのパッチを一連のデータとして扱っています。大規模な一般画像データセットで事前学習した後に、専門分野でのデータを用いて追加的な学習を行うことでモデルを微調整する「ファインチューニング(fine tuning)」によって、さまざまな専門分野でも高い精度が得られます。インフラ点検の損傷画像などデータ数が限られる場合にも有望なアプローチであると考えられます。なお、大規模言語モデルでも、専門分野の文章を追加してファインチューニングできます。

下図は、点検画像と、その画像に対応するアテンションを表示したアテンションマップの例です。剥落(はくらく)やひび割れなど、損傷に関連する領域が強調されるようにアテンションが高くなっています。

このように、大規模言語モデルのベースとなるTransformerは、言語のみならず、画像などの多様なデータに適用できるのです。言語、画像、センサーデータなどを組み合わせたマルチモーダルなデータへの拡張も可能です。実務でも、点検調書のように、画像と言語からなるマルチモーダルなデータを用いる場面も多いため、大規模言語モデルの発展とともに、これから本格的に応用が広がっていくことが期待されます。

関連記事

AI:建築内装CGパースを完全無料で制作するサービス「PersGPT」

AI:建築内装CGパースを完全無料で制作するサービス「PersGPT」

ユニオンテックは、CGパースを無料で制作可能なWebサービス「PersGPT」をリリースした。依頼から修正まで完全無料となっており、依頼から24時間以内に出来上がった初版をメールで受け取ることができる。 ChatGPT:「ChatGPT」がBIMソフトのトラブル解決策を即答、mignの建設特化AIモデル「chact」に追加機能

ChatGPT:「ChatGPT」がBIMソフトのトラブル解決策を即答、mignの建設特化AIモデル「chact」に追加機能

ChatGPTをベースに建設分野に特化して開発したAIモデル「chact」に、新機能が追加された。最新の言語モデルとなるGPT-4を活用して、BIMソフトのエラーが生じた際に内容をコピー&ペーストするだけで解決策を回答する。 AI:建設法規の疑問に「ChatGPT」の建設特化モデル「chact」が回答 「東京都でトンネル工事の規制は」に何と答える?

AI:建設法規の疑問に「ChatGPT」の建設特化モデル「chact」が回答 「東京都でトンネル工事の規制は」に何と答える?

mignがChatGPTの言語モデルに建設関連法規を学習させた「chact」の提供を開始した。建築基準法などの法令に関する質問をチャットで投げると、AIが即時に回答するため、これまで手間だった法規の制限や解釈に関する行政への問い合わせや提携事業者とのやりとりなどが解消される。 クラウド:「ChatGPT」のAPIをBoxに搭載した新機能「Box AI」 国内進出10周年を迎えたBox Japanが抱く日本市場への期待

クラウド:「ChatGPT」のAPIをBoxに搭載した新機能「Box AI」 国内進出10周年を迎えたBox Japanが抱く日本市場への期待

Box Japanは2023年5月18日、国内での事業戦略に関する記者説明会を開催した。会場には、米Boxの共同創業者兼CEOのアーロン・レヴィ氏がオンラインで登場。日本市場で感じている手応えを語りつつ、同月に発表した新サービス「Box AI」についても詳しく紹介した。 スマートメンテナンス:三井住友建設が橋梁床版の維持管理を省力化するシステムを開発 ロボットとAI、自動設計で作業時間を半減

スマートメンテナンス:三井住友建設が橋梁床版の維持管理を省力化するシステムを開発 ロボットとAI、自動設計で作業時間を半減

三井住友建設は、既設橋梁(きょうりょう)の鉄筋コンクリート(RC)床版の維持管理で、ロボットとAI、自動設計ソフトを用いて、一連の業務を省力化する「床版維持管理システム」を開発した。 導入事例:戸田建設が測量機器の盛替え不要の自動連続測量システムを開発

導入事例:戸田建設が測量機器の盛替え不要の自動連続測量システムを開発

戸田建設は、ステレオカメラを用いた新たな自動測量技術「MWMSマームシステム(Measuring Worm Method system)」を開発した。 建設ICTで切り拓く、現場の安全衛生と生産性の向上(3):【第3回】建設テックで検査・点検の業務に省力化を(後編)―導入し易い配筋検査や遠隔臨場の建設ICT

建設ICTで切り拓く、現場の安全衛生と生産性の向上(3):【第3回】建設テックで検査・点検の業務に省力化を(後編)―導入し易い配筋検査や遠隔臨場の建設ICT

連載第3回は、前回に続き、検査/検測の業務を対象に省力化をもたらし、さらに安価な機材と実用的なシステムで比較的導入のハードルが低い建設ICTツールを紹介します。

Copyright © ITmedia, Inc. All Rights Reserved.

人気記事トップ10

- 虎の門ヒルズ45階「攻殻機動隊展」への誘導をARでエンタメ化 移動時間で作品世界へ没入体験

- 点群データをCADで扱える3Dモデルに変換するWebサービス、東大発ベンチャーbestat

- 前田建設が一級土木施工管理技士の学習アプリ「サクシェアPASS」公開

- アイリスグループが警備ロボット事業に本格参入 SEQSENSEを子会社化

- 作業員の熱中症リスクを深部体温センサーで早期検知、鉄建など3社が開発 26年春発売を予定

- AIとデジタルツインで発電所のひび割れ点検を自動化、清水建設とリコー

- なぜ「維持管理BIM」が定着しないのか BIM×クラウドと“業務フロー”視点の導入術【BIM×FM第11回】

- ドローンレース経験を非GPS環境の橋梁点検に活用 DRONE SPORTSと長大が海外視野に実証

- 新名神高速工事に鹿島の自動化施工システム「A4CSEL」を初適用 盛土作業を自動化

- 再エネ駆動のクローラークレーン活用と次世代バイオ燃料適用を拡大、旭化成ホームズ