ChatGPTで急速に進化する“生成AI”に抱く「驚異」と「脅威」 東大教授・川原圭博氏が示す建設での可能性:Archi Future 2023(2/3 ページ)

加速する生成AIとLLMの進化と、日本で活用していく際の課題

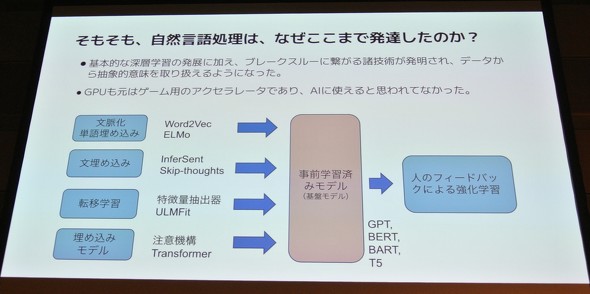

川原氏は、専門的な解説を交えながら、生成AIやLLMの歴史について、1960年代の第一次AIブームから最新の第三次AIブームまでの流れと、それぞれの時代にキーとなった技術とともに説明した。

そのうえで、生成AIやLLMは今後、マルチモーダルなものへと進化すると予測し、しかも進化の速度は自分が想定していたよりも速くなっていると指摘した。マルチモーダル化とは、端的にいうと、画像を扱え、ロボット制御に適用など、文章以外にも拡張されていくということ。川原氏は、2023年10月の画像生成AIを実装したChatGPTの登場は、2023年前半に自身が予測したスピードよりも2倍速いと驚く。そしてマルチモーダル化が加速することで、「生成AIがロボット制御や建機を操作するような社会の到来は、5、6年先のことかと予想していたが、もう少し早く実現するかもしれない」との展望を口にした。

5年、10年以上先になると、情報通信以外の分野でも生成AIの積極的な活用が始まるとも予測。そうした将来像を描くとき、現在の日本には不利な点が多いと警鐘を鳴らす。

なぜなら、日本は中国やアメリカと比べてAI研究がかなり遅れており、追いつかねばならない。ただ、研究に使えるGPUの数が圧倒的に足りていないのが現状だ。日本では、研究者が使用できる公的なGPUは1000枚くらいしかない。しかし、米国は、OpenAIのような民間企業が1社で数万枚を所有している。GPUは高額で、昨今の半導体不足から生産にも時間がかかる。こうしたディスアドバンテージに対し、「今後は国がサポートしながら研究者が使用できる環境を整えられるかが喫緊の課題だ」(川原氏)。

川原氏は、LLMは世界の数社が独占する技術ではあってはならず、「オープンなものとして透明性があり、原理も広く公開しながら、良い面も悪い面も含め、世の中の人とシェアしながら開発する必要がある」と考えている。また、特定の分野で大成功を収めたベストプラクティスがあれば、分野を超えて共有して、他分野にも波及させる流れをつくることも欠かせないと指摘する。

LLMの弱点にいかに向き合うか

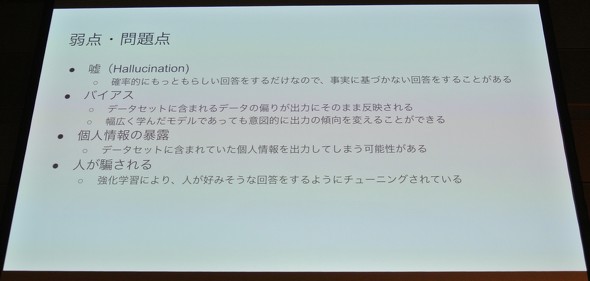

川原氏の指摘する生成AIやLLMが抱える悪い面とは何か?その一つは「ハルシネーション(Hallucination)」。ハルシネーションとは、日本語に翻訳すると「幻覚」で、この場合、「AIが幻覚でも見ているかのように、もっともらしいウソをつく」という意味だ。「生成AIが導き出す回答には、必ずしもファクトに基づいてないものもある。特にデータ量が足りていないケースでは、適当な回答をしてしまうことがある」(川原氏)。

さらに、LLMは質問者が好む回答を導き出す傾向があり、専門分野ならば回答の真偽を判断できるが、専門外の領域ならば回答が正しいものかはすぐには分からない。そのため、川原氏はLLMに頼りすぎないことが大切だと注意を促した。

他にもLLMは、データセットの偏りがそのまま出力に反映するため、回答にバイアスが生じたり、データセットに含まれていた個人情報が意図せず暴露されてしまったりなどの課題もある。

バイアスとまではいかなくても、データセットの偏りで回答の質に濃淡が出る弱点もある。例えばChatGPTだと、学習している日本語のデータは全データの1%未満といわれており、どうしても日本の時事や文化に対する回答が浅い内容になりがち。川原氏は、こうした弱点は建設分野にLLMを使用する場合にも壁になるとして、「建設分野で使用する際は、建設業界の独特な用語の使い方や物の考え方を反映しないと、本当に良いものにはならないだろう」と注意を促す。

Copyright © ITmedia, Inc. All Rights Reserved.

人気記事トップ10

- 虎の門ヒルズ45階「攻殻機動隊展」への誘導をARでエンタメ化 移動時間で作品世界へ没入体験

- 点群データをCADで扱える3Dモデルに変換するWebサービス、東大発ベンチャーbestat

- なぜ「維持管理BIM」が定着しないのか BIM×クラウドと“業務フロー”視点の導入術【BIM×FM第11回】

- 建設業の給与、2024年は0.3%減で足踏み状態 2025年の見通しは?【独自調査】

- ドローンレース経験を非GPS環境の橋梁点検に活用 DRONE SPORTSと長大が海外視野に実証

- 前田建設が一級土木施工管理技士の学習アプリ「サクシェアPASS」公開

- 再エネ駆動のクローラークレーン活用と次世代バイオ燃料適用を拡大、旭化成ホームズ

- 施工管理をもっと効率化 関電工の計測アプリと連携など「eYACHO」最新版

- 照明デザイナー石井幹子氏の「メゾン・エ・オブジェ・パリ」出展にオカムラが協力 特別仕様の電動昇降デスクなど制作

- トンネル覆工シート接着工の機械化施工技術を開発、下地処理と塗布工をロボットが代替 熊谷組