言語モデルはどのように言葉を学習しているのか? 転機となった「word2vec」【土木×AI第25回】:“土木×AI”で起きる建設現場のパラダイムシフト(25)(1/2 ページ)

連載第25回は、目覚ましい進化を続ける生成AIの理解を深めるため、言語モデルに用いる“ニューラルネットワーク”が、どのように言葉を学習しているのかを土木学会の最新研究を引用しながら探ります。

生成AIの発展はとどまるところを知りません。最近では、国立情報学研究所に大規模言語モデル研究開発センターが設立されるなど、官民挙げた取り組みも活発化しています※1。生成AIのさらなる利活用には、基盤となる言語モデルへの理解がますます求められます。では、人間の脳内にある神経細胞(ニューロン)のネットワークを機械学習モデルで模し、言語モデルに用いる“ニューラルネットワーク”は、どのように言語を学習しているのでしょうか?

ニューラルネットワークに言葉を教える「分散表現」と「word2vec」

ニューラルネットワークに言葉を教える方法で、すぐに思い付くのは、「1つのニューロンに1つの言葉を覚えさせたらどうか」ということです。しかし、この方法では言葉の数が増えるにつれ、ニューロン数も増やさないとなりませんし、「大きな」「白い」「犬」のような複合的な概念を表すのも簡単ではありません。

そこで考えられたのが「分散表現」で、言葉を複数のニューロンに分散して対応させています。分散表現では、言葉の特徴量が多次元のベクトルで表されます。それに対して前者の方法は、単一の局所的要素で表されるため、「局所表現」と呼ばれます。

★連載バックナンバー:

本連載では、土木学会 構造工学でのAI活用に関する研究小委員会で副委員長を務める阿部雅人氏が、AIと土木の最新研究をもとに、今後の課題や将来像について考えていきます。

分散表現をニューラルネットワークで求める画期的な方法が2013年に登場した「word2vec」です※2。「単語をベクトルに(word to vector)」を縮めた名前になっています。言語が分散表現として数値化されることで、コンピュータにとって扱いやすくなりました。分散表現を求めることを、ベクトル空間への「エンベディング(埋め込み:embedding)」とも言います。

一方、言語学では、「単語の意味は、その周囲に分布している単語によって形成される」という「分布仮説」が1950年代に提案されています。私たちも、知らない言葉があった時に、その前後の関係や文脈から、言葉の意味を類推することがあるでしょう。

分布仮説は、言語モデルにも取り入れられており、word2vecも単語の意味を、周辺に現れる単語の頻度で表現するように学習しています。それによって、意味が似ている単語の分散表現は、近い位置に配置されます。ベクトル演算を行うと、「King - Man + Woman = Queen」などの意味を反映した興味深い関係が成り立つことが知られています。

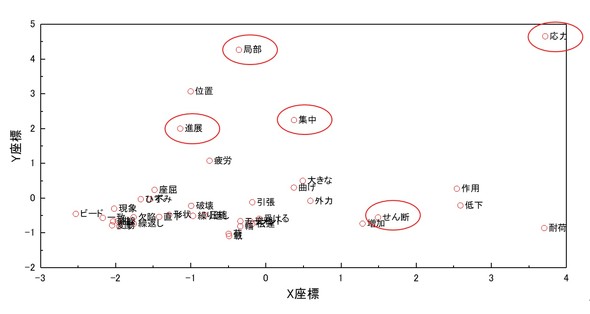

点検や補修補強などのテキストにword2vecを適用し、「応力」に関連性が高い単語を可視化した結果を下図に示しました※3。「局部」「集中」などの言葉が近くにあります。

※3 「土木工学におけるAI応用チュートリアル(6)」杉崎光一/土木学会 構造工学委員会 構造工学でのAI活用に関する研究小委員会

分散表現では、類似の言葉が近い位置に配置されるため、それを利用して分類をすることができます。例えば、工事書類を分類したり※4、前回の連載で取り上げたような地域特性※5や消費特性※6を分類したりなどの例が出てきています。

Copyright © ITmedia, Inc. All Rights Reserved.