ChatGPTの新機能「GPT-4V」など、言語と画像のマルチモーダルAIを土木に用いるアイデア【土木×AI第22回】:“土木×AI”で起きる建設現場のパラダイムシフト(22)(1/2 ページ)

連載第22回は、文字だけでなく、画像入力や音声出力も可能になったChatGPTの新機能「GPT-4V」や先立つこと2021年に登場した「CLIP」など、言語と画像のマルチモーダルなAIを土木の実業務に活用するアイデアを紹介します。

点検の際に目視に基づいて所見を記載するなど、画像を見てその説明を記述するような業務は土木では一般的です。

2023年9月25日に発表されたChatGPTの新機能「GPT-4V」は、テキストと画像の両方を取り扱え、画像から説明文を生成するなど、多岐にわたるユースケースが考えられています※1。日常的な内容については、かなり質の高い文章生成が可能となってきています。さらに、土木などの“専門知”を取り入れられれば、実業務のデジタルトランスフォーメーション(DX)に大いに寄与すると考えられます。

GPT-4VをLMMとして活用

文献1では、これまでの「大規模言語モデル(LLM:Large Language Model)」に対し、GPT-4Vを「大規模マルチモーダルモデル(LMM:Large Multimodal Model)」と位置付け、幅広いユースケースのアイデアを提示しています。

例えば、

・間違い探し:2つの画像から違いを見つける

・産業利用:損傷検出、安全点検、食料品店での買い物かご画像からの会計

・医療利用:レントゲン画像などの説明

・自動車保険:事故損傷写真からの損害査定、保険報告作成

・カスタマイズ:固有名詞などの事例にあわせた画像の説明

・画像生成:生成画像の評価、画像編集のためのプロンプト生成

・身体エージェント(embodied agent:物理的あるいは仮想的に環境に作用するエージェント):機械の操作、移動

・GUIナビゲーション:Webブラウジング、オンラインショッピング、通知の理解、動画の理解

などがあります。実用化にはまだまだ課題もありますが、大きな可能性を感じさせてくれます。

★連載バックナンバー:

本連載では、土木学会 AI・データサイエンス実践研究小委員会 副委員長を務める阿部雅人氏が、AIと土木の最新研究をもとに、今後の課題や将来像について考えていきます。

画像とテキストのペアを予測する画期的な「CLIP」

画像とテキストを関連付ける方法としては、2021年に登場した「CLIP(Contrastive Language-Image Pre-training:言語と画像の対照事前学習)」は当時としては画期的なものでした※2。

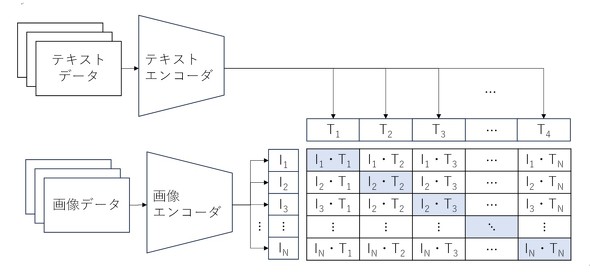

CLIPでは、下図のように画像と対応するテキストのペアを同時に学習させます。まず、テキストと画像をそれぞれエンコーダーで、「エンベディング(embedding:埋め込み)」します。エンベディングとは、コンピュータ上で画像や言語を取り扱いやすくするために、画像や文章をその特徴を反映したベクトル表現に変換することです。

エンベディングの際、類似したものは近いベクトルに変換されるように学習するところがポイントです。画像を埋め込んだベクトルと言語を埋め込んだベクトルが正しく対応する場合はスコアが大きく、対応しない場合はスコアが小さくなるように学習します。この仕組みを表したのが下図であり、表の対角線上の組み合わせが正しい対応関係を表します。

Copyright © ITmedia, Inc. All Rights Reserved.